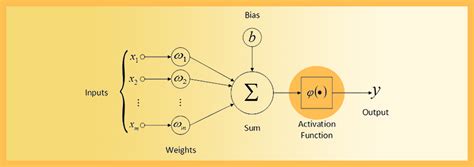

В мире машинного обучения существует широкий спектр алгоритмов для обработки и классификации данных. Одним из наиболее популярных методов является функция активации softmax, которая играет важную роль в многочисленных задачах, связанных с обработкой информации и принятием решений.

Данная функция, также известная как "максимальный синус" или "логарифмическая компонента потери", позволяет моделировать нелинейные зависимости между входными и выходными данными. Благодаря использованию функции softmax, нам открывается широкий спектр возможностей для обработки сложных исходных данных и их последующего анализа.

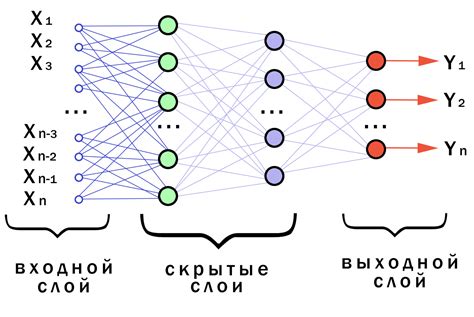

Главной задачей функции активации softmax является нормализация входных данных таким образом, чтобы сумма всех выходных значений на выходном слое была равна 1. Это позволяет интерпретировать результаты как распределение вероятностей и использовать их для классификации объектов. Данный метод является важной составляющей в обработке изображений, анализе текстов и других типов данных, где требуется вероятностный подход к решению задачи.

Особенности операции максимума в нейронной активации

Преобразование в вероятностное распределение

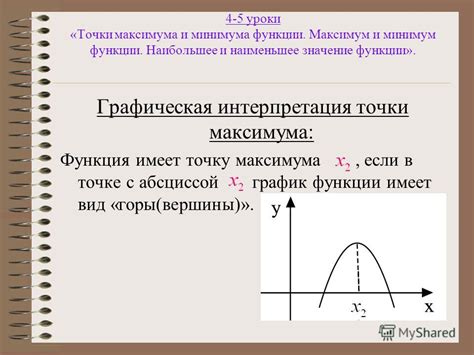

Функция активации softmax является инструментом, позволяющим преобразовать вектор значений входных данных в вероятностное распределение. Она основана на операции максимума, которая выбирает наибольшее значение среди всех элементов вектора. Таким образом, softmax позволяет установить наиболее вероятное значение входных данных и отклонить остальные варианты.

Гибкость и интерпретируемость

Функция активации softmax позволяет работать с многомерными данными и обладает свойством нормировки, что означает, что сумма всех исходных значений равна единице. Это дает гибкость для применения данного метода в различных областях, таких как классификация, регрессия и генерация текста. Более того, полученные вероятности могут быть интерпретированы как меры уверенности модели в принятии решений.

Преимущества и недостатки

Функция активации softmax имеет некоторые преимущества, такие как гибкость в работе с многомерными данными и возможность интерпретации вероятностей. Однако, также следует учитывать, что softmax может привести к проблеме затухания градиента и переобучению модели, особенно при обработке больших объемов данных.

В данном разделе мы рассмотрели функцию активации softmax, которая является мощным инструментом для преобразования входных данных в вероятностное распределение. Она обладает гибкостью и интерпретируемостью, однако имеет свои преимущества и недостатки, которые следует учитывать при ее применении.

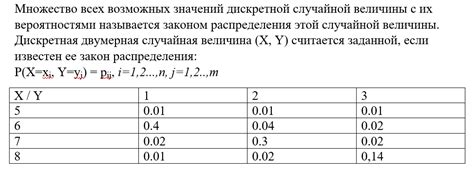

Математическое описание функции, обеспечивающей распределение вероятностей на основе значений входного вектора

В данном разделе будет представлено математическое описание функции, которая возвращает распределение вероятностей для каждого элемента входного вектора. Эта функция обеспечивает нормализацию значений входного вектора и позволяет представить их в виде вероятностей.

Для начала, важно отметить, что функция, о которой идет речь, используется в задачах классификации, где требуется определить вероятности принадлежности входного объекта к каждому классу. Функция softmax выполняет эту задачу, преобразуя значения входного вектора в вероятностные оценки.

Математически, функцию softmax можно определить следующим образом. Пусть имеется входной вектор размерности n, обозначим его как x = (x1, x2, ..., xn). Для получения вероятностей, необходимо применить к каждому элементу вектора экспоненциальную функцию, и затем нормализовать полученные значения. Степень экспоненты представляет собой "степень уверенности" в определенном классе. Нормализация выполняется путем деления каждого элемента на сумму всех экспоненциальных значений вектора.

| Элемент входного вектора | Экспоненциальное значение | Вероятностная оценка |

|---|---|---|

| x1 | e^(x1) | e^(x1) / (e^(x1) + e^(x2) + ... + e^(xn)) |

| x2 | e^(x2) | e^(x2) / (e^(x1) + e^(x2) + ... + e^(xn)) |

| ... | ... | ... |

| xn | e^(xn) | e^(xn) / (e^(x1) + e^(x2) + ... + e^(xn)) |

Таким образом, функция softmax представляет собой математическое описание процесса преобразования значений входного вектора в вероятностные оценки. Это позволяет использовать эти оценки для классификации объектов с помощью методов, основанных на вероятностных моделях.

Роль функции экспоненциального взвешенного среднего в нейронных сетях

Функция активации softmax играет ключевую роль в нейронных сетях, обеспечивая нормализацию и интерпретацию выходов сети в вероятностном контексте. Эта функция позволяет преобразовывать вектор значений, полученных от предыдущего слоя, в вероятностное распределение, где каждый элемент вектора представляет собой вероятность принадлежности к определенному классу или категории.

Функция активации softmax использует экспоненциальную функцию для взвешенного суммирования значений, полученных от предыдущего слоя. Затем происходит нормализация этих взвешенных значений путем деления каждого соответствующего элемента на сумму всех элементов вектора. Такая нормализация позволяет преобразовывать сырые выходы нейронной сети в вероятности, сумма которых равна единице, что удобно для интерпретации результата.

Применение функции активации softmax особенно полезно в задачах классификации, где требуется определить, к какому классу принадлежит входные данные. Данный подход позволяет сети возвращать уверенности в принадлежности данных к каждому классу, устанавливая оптимальные пороговые значения для принятия решений. Кроме того, функция softmax обладает свойством дифференцируемости, что позволяет использовать ее в градиентном спуске и обучении нейронных сетей.

Преимущества применения функции мягкого максимума

Когда мы рассматриваем вопрос использования определенной функции активации в нейронных сетях, становится ясно, что применение функции мягкого максимума (softmax) может принести нам множество пользы и отличаться своими преимуществами.

- Универсальность: функция мягкого максимума может применяться в различных областях машинного обучения и искусственного интеллекта, включая задачи классификации, сегментации изображений и распознавания голоса;

- Нормализация: softmax функция обеспечивает нормализацию вероятностей классов, поэтому сумма всех вероятностей классификации будет равняться 1, что упрощает интерпретацию результатов;

- Очевидность интерпретации: softmax функция позволяет нам получить вероятности для каждого класса, что делает предсказания модели более понятными и интерпретируемыми;

- Подавление выбросов: функция мягкого максимума способна преобразовывать большие числа в промежуток от 0 до 1, что помогает избежать больших значения и подавить эффект выбросов;

- Градиентный спуск: использование softmax функции позволяет нам применять алгоритм обратного распространения ошибки для настройки параметров нейронной сети, что является ключевым инструментом обучения моделей глубокого обучения.

Применение функции активации softmax в нейронных сетях имеет ряд значимых преимуществ, а именно - универсальность, нормализацию вероятности классов, возможность интерпретации предсказаний модели, подавление выбросов и градиентный спуск для обучения. Отличительная особенность softmax заключается в том, что она позволяет нам работать с вероятностями классов и делает модель более понятной и гибкой во многих областях машинного обучения.

Ограничения и сложности функции мягкого максимума

В данном разделе рассмотрим некоторые ограничения и сложности, связанные с использованием функции мягкого максимума в нейросетях. Данная функция широко применяется в машинном обучении для получения вероятностных распределений, однако она не лишена некоторых проблем.

1. Рассеянность вероятностей: При использовании функции мягкого максимума возможно получение относительно равных значений вероятностей для разных классов. Это может быть проблемой в случаях, когда необходимо получить чёткую классификацию или при многоклассовой классификации с целью отнести объект только к одному классу.

2. Чувствительность к выбросам: Функция мягкого максимума может быть чувствительна к выбросам во входных данных. Небольшое изменение значений входных данных может привести к существенным изменениям в распределении вероятностей. Это может быть проблемой при работе с шумными или недостаточными данными.

3. Вычислительная сложность: Вычисление функции мягкого максимума требует вычисления экспоненты для каждого элемента вектора. При большом размере вектора и большом количестве классов это может вызвать вычислительные проблемы и требовать значительных вычислительных ресурсов.

4. Недифференцируемость: Функция мягкого максимума не является дифференцируемой. Это может быть проблемой при использовании градиентных методов оптимизации, которые требуют вычисления производных функции. Для решения этой проблемы могут применяться альтернативные функции активации или различные модификации методов оптимизации.

Оптимальное использование функции "Максимальное преимущество"

В данном разделе мы рассмотрим практический пример применения функции активации, которая обеспечивает оптимальное использование наиболее выгодного элемента.

Для достижения наилучшего результата в задачах классификации, где необходимо прогнозировать принадлежность объекта к одному из нескольких классов, функция активации softmax позволяет эффективно распределить вероятности между разными классами. В этом случае, принципом работы функции является учет значений исходных данных и их преобразование в вероятности таким образом, чтобы класс с наибольшим значением имел наибольшую вероятность быть выбранным.

Представим себе задачу распознавания изображений, где необходимо определить, принадлежит ли каждое изображение к одному из нескольких классов: кошки, собаки или птицы. В данном случае, функция активации softmax позволяет определить вероятность принадлежности каждого изображения к каждому классу. Например, если у модели есть изображение с кошкой, функция активации softmax поможет рассчитать вероятности, что это изображение может быть кошкой, собакой или птицей. Данная функция обеспечивает приемлемый способ многоклассовой классификации, позволяя выбрать наиболее вероятный класс для каждого изображения.

Оптимальное использование функции "Максимальное преимущество" позволяет повысить точность классификации и уменьшить вероятность неправильной классификации. Применение данной функции активации в задачах машинного обучения исключительно важно, так как она способствует достижению высоких показателей точности и надежности моделей, обученных на многоклассовых данных.

Альтернативные методы активации в сравнении с функцией softmax

В данном разделе мы проведем сравнительный анализ альтернативных методов активации, используемых в нейронных сетях, с целью выявить их преимущества и особенности по сравнению с широко применяемой функцией активации softmax.

Прежде чем перейти к детальному рассмотрению каждого из альтернативных методов, важно обратить внимание на то, что выбор функции активации имеет существенное влияние на работу нейронной сети. Каждый метод имеет свои уникальные особенности, которые могут быть полезны в различных сценариях.

Одним из альтернативных методов является функция активации ReLU (Rectified Linear Unit). Она основывается на простой идеи отсечения значений, меньших нуля, и оставляет остальные значения без изменений. Такой подход позволяет достичь лучшей скорости обучения и улучшения обобщающей способности сети.

Другим интересным методом является функция активации Sigmoid, которая преобразует входные значения в диапазон от 0 до 1. Это особенно полезно при работе с задачами классификации или задачами, требующими вероятностных интерпретаций.

Также стоит обратить внимание на функцию активации Hyperbolic tangent (tanh), которая отображает значения в диапазон от -1 до 1. Она широко применяется в рекуррентных нейронных сетях и позволяет обрабатывать последовательности данных, сохраняя информацию о временных зависимостях.

Это лишь некоторые из альтернативных методов активации, которые можно использовать вместо функции softmax. Каждый метод имеет свои достоинства и недостатки, и выбор наиболее подходящего зависит от специфики задачи и требований к нейронной сети.

Вопрос-ответ

Какие принципы лежат в основе работы функции активации softmax?

Функция активации softmax основана на принципе преобразования вектора значений в вероятностное распределение. Она применяется для многоклассовой классификации, где каждый класс должен быть присвоен определенной вероятности.

Что происходит при использовании функции активации softmax?

При использовании функции активации softmax, экспоненциальные значения каждого элемента вектора преобразуются в вероятности соответствующих классов. Сумма всех вероятностей равна 1, что позволяет интерпретировать выходные данные как вероятности принадлежности к классам.

Как можно использовать функцию активации softmax?

Функция активации softmax может использоваться в моделях глубокого обучения для решения задач классификации, например, для определения объекта на изображении или классификации текстов. Она обеспечивает гладкую активацию и легко интерпретируемые результаты.

Какие преимущества имеет функция активации softmax?

Функция активации softmax имеет несколько преимуществ. Она позволяет получить вероятностное распределение для каждого класса, что удобно при принятии решений. Кроме того, она обеспечивает гладкую и непрерывную активацию, что полезно при градиентном спуске и обратном распространении ошибки.